книги / Нечёткое, нейронное и гибридное управление

..pdf

мозга. Кора человеческого мозга представляет собой большую поверхность, площадью приблизительно 0,5 м2, свернутую складками. Поверхность характеризуется определенными свойствами: например, участок, ответственный за ступни ног, примыкает к участку, контролирующему движение всей ноги и т.д., т.е. все элементы человеческого тела отображаются на эту поверхность [9]. В процессе обучения ИНС на основе обучающей записи устанавливается точка в структуре сети. Нейрон, который находится ближе других к этой точке, объявляется нейроном-победителем.

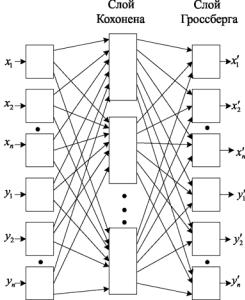

Рис. 2.9. Сеть встречного распространения

Веса связи, соединяющие этот нейрон с другими нейронами, увеличиваются и тем самым происходит целенаправленное упорядочение сети. Веса от нейронов, являющихся «соседями» нейронапобедителя, к другим нейронам также увеличиваются, но в меньшей мере. Для данного входного вектора один и только один ней-

151

рон Кохонена выдает на выходе логическую единицу. Сеть Кохонена можно рассматривать как набор электрических лампочек и для любого входного вектора загорается одна из них. Поэтому трудно предсказать, какой именно нейрон Кохонена будет активизироваться для заданного входного вектора. В конце обучения сеть превращается в набор зон сосредоточения нейронов, именуемых кластерами. Перед началом обучения необходимо гарантированно добиться, чтобы несхожие входные векторы разделялись и желательно, чтобы они были нормализованы перед тем, как их предъявить сети. Данная операция выполняется с помощью деления каждой компоненты входного вектора на длину вектора. Таким образом, входной вектор превращается в единичный вектор с тем же самым направлением, т.е. векторединичнойдлинывn-мерномпространстве[9]:

si |

|

xi |

. |

||

x2 |

x2 |

... x2 |

|||

|

|

||||

1 |

2 |

n |

|

||

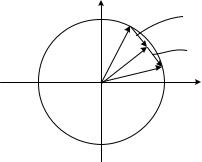

Пример 2.1. Пусть вектор V с двумя компонентами согласно теореме Пифагора представлен в координатах x и у, где координата x = 4, а координата y = 3. Квадратный корень из суммы квадратов этих компонент равен пяти. Деление каждой компоненты на пять

дает вектор с компонентами 45 и 35 , где вектор V имеет еди-

ничную длину 55 . На рис. 2.10 показано формирование единично-

го вектора.

Когда у входного вектора два компонента, то вершины компонент единичных векторов лежат в плоскости единичной окружности на ее образующей. Для трех компонент входного вектора концы компонент лежат в пространстве внутри оболочки единичной сферы, если больше, то внутри оболочки на образующей – единичной гиперсфере.

При обучении сети Кохонена на вход подаются компоненты входного вектора и вычисляются их скалярные произведения с компонентами вектора весов, связанных со всеми нейронами Кохонена.

152

Рис. 2.10. Формирование единичного вектора

Нейрон с максимальным значением скалярного произведения объявляется победителем. Так как скалярное произведение является мерой сходства между компонентами входного вектора и компонентами вектора весов, то процесс обучения состоит в выборе нейрона Кохонена с весовым коэффициентом, наиболее близким к конкретной компоненте входного вектора, и в дальнейшем приближении компоненты весового вектора к компоненте входного вектора. Сеть самоорганизуется так, чтобы данный нейрон Кохонена имел максимальный выход для данного входной компоненты вектора. Уравнение, описывающеe процесс обучения, имеет вид

Wн Wс X Wc ),

где Wн – новое значение веса, соединяющего входную компоненту X с выигравшим нейроном; Wс – предыдущее значение этого веса;

– скорость обучения, которая может меняться в процессе обучения.

Каждый вес, связанный с выигравшим нейроном Кохонена, изменяется пропорционально разности между его величиной и величиной входа, к которому он присоединен. Направление изменения минимизирует разность между весом и его входом. На рис. 2.11 этот процесс показан в геометрическом виде.

153

Xi Wci

Wci |

X |

W |

|

i |

ci |

|

Wн |

|

|

X i |

|

Рис. 2.11. Геометрическая интерпретация процесса обучения сети Кохонена

Сначала определяем вектор X Wc , для этого проводится отрезок из конца Wc в конец X . Затем вектор умножаем на скалярную величину меньшую единицы, в результате чего получаем вектор изменения . Окончательно новый весовой вектор Wн явля-

ется отрезком, направленным из начала координат в конец вектора . Отсюда можно видеть, что эффект обучения состоит во вращении весового вектора в направлении входного вектора без существенного изменения его длины.

Если бы с каждым нейроном Кохонена ассоциировался один входной вектор, то сеть Кохонена могла быть обучена с помощью одного вычисления. Веса нейрона-победителя приравнивались бы к компонентам обучающего вектора Как правило, обучающее

множество включает много сходных векторов и сеть должна быть обучена активировать один и тот же нейрон Кохонена для каждого из них. В этом случае веса этого нейрона должны вычисляться усреднением компонент входного вектора, которые его активируют. Постепенное уменьшение величины уменьшает воздействие каждого обучающего шага, и окончательное значение будет средней величиной от входных векторов, на которых происходит обучение.

154

Таким образом, веса, ассоциированные с нейроном, примут значение вблизи «центра» входных векторов, для которых данный нейрон является победителем.

Искусственная нейронная сеть С. Гроссберга. Семейство ИНС, построенное на основе теории адаптивного резонанса (ART), разработанной С. Гроссбергом [9] применительно к биологическим структурам, обладает свойствами стабильности и пластичности, т.е. сети АRT могут обучаться новым данным, не теряя при этом ранее накопленную информацию.

Принцип адаптивного резонанса, заключающегося в свойстве АRT-сети, – иметь внутренний детектор новизны, т.е. тест на сравнение предъявленного образа с содержимым памяти. При удачном поиске в памяти возникает адаптивный резонанс в сети в ответ на предъявление образа. Если резонанс не возникает в пределах некоторого заданного порогового уровня, то тест считается успешным и образ воспринимается сетью как новый. Модификация весов нейронов, не испытавших резонанса, при этом не производится. Запомненный образ не будет изменяться, если текущий входной вектор не окажется достаточно похожим на него. Так решается проблема ста- бильности-пластичности. Новый образ может создавать новые классы, при этом существующая память не нарушается [9].

Слой Гроссберга обучается относительно просто. Входной вектор, являющийся выходом слоя Кохонена, подается на слой нейронов Гроссберга. Выходы слоя Гроссберга вычисляются как при нормальном функционировании. Далее, каждый вес корректируется только в том случае, если он соединен с нейроном Кохонена, имеющим ненулевой выход. Величина коррекции веса пропорциональна разности весов и требуемому выходу нейрона Гроссберга, с которым этот вес соединен. В символьной записи

ijн ijc yj ijc )ki ,

155

где ki – выход i-го нейрона Кохонена, выход которого не равен нулю; yj – j-я компонента вектора желаемых выходов; ijн, ijc – но-

вый и старый выход нейрона Гроссберга.

Первоначально берется приблизительно 0,1 и затем посте-

пенно уменьшается в процессе обучения. Обучение слоя Гроссберга осуществляется с учителем, т.е. алгоритм располагает желаемым выходом, по которому он обучается. В режиме нормального функционирования предъявляются входные векторы X и Y, и обученная сеть дает на выходе векторы X иY , являющиеся аппроксимация-

ми соответственно для X и Y. Векторы X и Y предполагаются здесь нормализованными единичными векторами, следовательно, порождаемые на выходе векторы также будут иметь тенденцию быть нормализованными. В процессе обучения векторы X и Y подаются одновременно и как входные векторы, и как желаемые выходные сигналы. Вектор X используется для обучения выходов X , а вектор

Y – для обучения выходов Y слоя Гроссберга. Сеть встречного распространения целиком обучается с использованием того же самого метода, который описывается для сети прямого действия.

Уникальная способность сети встречного распространения – порождать функцию и обратную к ней – делает эту сеть полезной в приложениях: сжатие данных и векторного квантования.

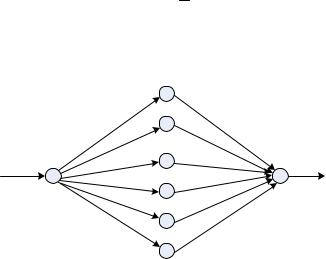

Радиально-базисные (RBF) нейронные сети

Рассмотрим перспективные радиально-базисные ИНС в отличие от многослойных ИНС персептронного типа, которые обеспечивают более быстрое обучение за счет использования комбинированного алгоритма обучения. Радиально-базисная (RBF) сеть пока-

зана на рис. 2.12 [9, 37].

Данная сеть имеет один промежуточный слой, состоящий из радиальных элементов, каждый из которых воспроизводит гиперсферу. Поскольку воспроизводимые базисные функции нелинейны, то нет необходимости выбирать более одного промежуточного слоя. Для

156

моделирования любой функции достаточно взять определенное число радиальных элементов с формулой Гаусса

x2

f (x) e 2 ,

где σ – ширина окна функции.

Рис. 2.12. Радиально-базисная нейронная сеть

Радиально-базисная сеть имеет следующие особенности: у нее только один скрытый промежуточный слой, и нейроны скрытого слоя используют вышеприведенную функцию Гаусса; коэффициенты связей входного слоя и скрытого слоя равны 1. Выход сети RBF формируется в результате комбинации выходов скрытых радиальных элементов. Сети RBF перед многослойными персептронами имеют ряд преимуществ:

–моделируют произвольную нелинейную функцию с помощью одного промежуточного слоя, поэтому избавляют разработчика от необходимости решать вопросы о числе слоев;

–параметры линейной комбинации в выходном слое можно полностью оптимизировать с помощью хорошо известных методов линейной оптимизации (при обучении отсутствует возможность попадания в локальный минимум, поэтому RBF обучается на поря-

157

док быстрее, чем многослойный персептрон. Однако в промежуточном слое для радиальных элементов необходимо определить положение их центров и величины отклонений.

RBF-сети обучаются при помощи комбинированных методов. На первом этапе проводится предварительная кластеризация для определения эталонных векторов с использованием алгоритмов обучения без учителя. На втором этапе – вычисление значений весов связей нейронов скрытого слоя с нейронами выходного слоя в общем случае с помощью алгоритмов обучения с учителем.

Для реализации первого этапа вначале случайным образом выбирается определенное число центров, которые образуют классы. В центре могут находиться случайно выбранные векторы из обучающей выборки [9].

2.4.2. Нейронные сети с обратной связью

Данные сети строятся также на базе искусственных нейронов. Отсутствие обратной связи гарантирует безусловную устойчивость сетей. Однако сети без обратных связей обладают более ограниченными возможностями по сравнению с сетями с обратными связями. Так как сети с обратной связью имеют пути, передающие сигналы с выхода на вход, то отклик таких сетей является динамическим, т.е. после приложения нового входа вычисляется выход и, передаваясь по сети обратной связи, модифицирует вход. Затем выход повторно вычисляется и процесс повторяется снова и снова. Сети могут быть устойчивыми и неустойчивыми. Рассмотренные сети без обратных связей имеют особенность, заключающуюся в том, что каждый нейрон выполняет свою функцию – передачу возбуждения другим нейронам только один раз. Несколько более сложной является динамика в сети Кохонена. Конкурентным соревнование нейронов достигается путем итераций, в процессе которых информация многократно передается между нейронами. Неитерационная динамика состояний нейронов является всегда устойчивой. Вопросы устойчивости сетей с обратными связями мало изучены. Однако част-

158

ным случаем являются сети Хопфилда и Хемминга, где сигнал с выхода слоя нейронов или нейронов скрытого слоя передается обратно на входы этого же слоя нейронов.

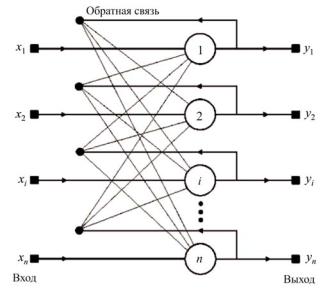

Сеть Хопфилда

В 80-е годы нейронными сетями, реализующими ассоциативную память, начал заниматься Дж. Хопфилд из Калифорнийского технологического института, который разработал частный вариант такой сети [9, 37]. Сеть Хопфилда состоит из единственного слоя нейронов, число которых является одновременно числом входов и выходов сети (рис. 2.13). Каждый нейрон связан со всеми остальными нейронами, а также имеет один вход, через который осуществляется ввод сигнала. В сети Хопфилда нейроны принимают решения асинхронно, связь между ними осуществляется мгновенно и все связи симметричны, т.е. wij wji .

Рис. 2.13. Структура нейронной сети Хопфилда

159

При этих ограничениях все возможные состояния сети образуют некое подобие холмистой поверхности, а текущее состояние сети аналогично поведению тяжелого шарика, пущенного на эту поверхность: он движется вниз по склону в ближайший локальный минимум. Каждая точка поверхности соответствует некоторому сочетанию активностей нейронов в сети, а высота подъема поверхности в данной точке характеризует «энергию» E этого сочетания (называемую функцией Ляпунова), которую можно представить следующим образом:

n |

n |

n |

|

E 0,5 wij yi |

y j xi y j ; |

i j, |

|

i 1 |

j 1 |

i 1 |

|

где wij – вес связи нейронов i и j; |

yi – выходной сигнал нейрона i; |

||

yj – выходной сигнал нейрона j; xi – входной сигнал нейрона i.

Нейронная сеть Хопфилда реализует существенное свойство – восстановление по искаженному (зашумленному) образу, ближайшему к нему эталонного. В этом случае входной вектор используется как начальное состояние сети, и далее сеть эволюционирует согласно своей динамике. Причем любой пример, находящийся в области притяжения хранимого образца, может быть использован как указатель для его восстановления. Выходной (восстановленный) образец устанавливается, когда сеть достигает равновесия. Структура НС (см. рис. 2.13) предполагает один слой нейронов, число которых определяет число входов и выходов сети. Выход каждого нейрона соединен с входами всех остальных нейронов. Подача входных векторов осуществляется через отдельные входы нейронов. Данная НС устойчива, если матрица ее весов симметрична и имеет нули на главной диагонали.

Сеть Хэмминга

Когда нет необходимости в том, чтобы сеть в явном виде выдавала образец, достаточно получать номер образца, ассоциативную

160