- •Лекция 1. Введение в компьютерное зрение

- •1. История фотографии

- •2. Что такое цифровая фотография, пзс матрица

- •3. Характеристики объектива

- •Цветовое пространство lab, зачем нужна метрика ciede2000?

- •3. Особенности восприятия света человеком, цветовое пространство xyz

- •8. Цветовое пространство cmyk

- •9. Что такое цветовой охват

- •10. Что такое OpenCv

- •6. Цветовое пространство hsv

- •7. Цветовое пространство yuv

- •8. Что такое размытие изображения, какие виды размытия бывают и где их применяют

- •9. Что такое оператор Собеля и зачем он нужен

- •10. Что такое оператор Лапласа и зачем он нужен

- •11. Что такое нелинейные фильтры, приведите примеры

- •12. Что такое медиана в контексте операций над изображениями

- •13. Что такое билатеральный фильтр и зачем он нужен

- •14. Что такое компоненты связности и морфология в контексте операций над изображениями

- •Лекция 4. Манипуляции с изображениями

- •1. Что такое свертка

- •Преобразование Фурье в контексте манипуляции с изображениями

- •4. Свойства преобразования Фурье, применение теоремы о свертке в контексте манипуляции с изображениями

- •5. Что такое спектр изображения и частотные фильтры? Дайте примеры их применения. Какая связь между частотными фильтрами и свертками?

- •Фильтры низких частот.

- •Высокочастотные фильтры.

- •1. Абсолютный фильтр

- •9. Увеличение изображения - билинейная и бикубическая интерполяция

- •10. Уменьшение изображения - оператор уменьшения

- •11. Что такое пирамида изображений. Что такое пирамида Гаусса и пирамида Лапласа? Как делается блендинг изображений

- •Геометрические преобразования.

- •Лекция 5. Особые точки и выделение границ Особые точки, интуитивное понятие особой точки.

- •3. Алгоритм Харриса для нахождения углов

- •Sift детектор особых точек.

- •Surf-дескриптор.

- •Brief дескриптор.

- •Orb алгоритм

- •Сопоставление дескрипторов

- •Алгоритм выделение границ Canny.

- •Лекция 6. Сверточные нейронные сети Что такое нейронная сеть: слои, функции активации

- •Что такое нейронная сеть: слои, функции активации

- •Объясните терминологию обучения нейронных сетей: что такое эпоха, шаг, скорость обучения и размер батча? Что такое функция потерь и какие они бывают?

- •Алгоритм стохастического градиентного спуска для обучения нейронных сетей

- •Как инициализируют веса в нейронных сетях? Что такое проблема затухающих и взрывающихся градиентов? Что такое инициализация Хе (Кайминга) и Ксавье?

- •Что такое сверточный слой? Как он работает и какие параметры имеет?

- •Размеры входного и выходного изображения

- •Что такое нормализация по мини-батчам (batch normalization) и как она работает

- •Что такое дропаут и как он работает

- •Задача классификации и функции потерь для этой задачи в контексте обучения нейронных сетей

- •Опишите типичную архитектуру сверточной нейронной сети

- •Слой свёртки

- •Слой активации

- •Пулинг или слой субдискретизации

- •Полносвязная нейронная сеть

- •Перечислите несколько архитектур сверточных нейронных сетей, разберите одну подробно, например ResNet

- •Что такое transfer learning и как его осуществляют в контексте классификации изображений?

- •Лекция 7. Сегментация и детекция Что такое задача сегментации? Какие бывают виды сегментации?

- •Опишите что такое полносверточная нейронная сеть (fully convolutional neural network)

- •Что такое транспонированная свертка и для чего она нужна? Какие у нее есть альтернативы?

- •Что такое u-net? Опишите архитектуру и приведите примеры ее современных вариаций. Как обучают u-net?

- •Что такое задача детекции объектов на изображении? Опишите архитектуру yolo. Как обучают yolo?

- •Что такое якоря в контексте архитектур yolo, Faster и Mask rcnn?

- •Алгоритм nms (non maximum suppression) в контексте нейросетевых архитектур детекции

- •Что такое задача детекции объектов на изображении? Чем одностадийная детекция отличается от двухстадийной? Опишите архитектуру Mask rcnn. Чем она отличается от Faster rcnn?

- •Что такое RoI pooling и чем он отличается от RoI align в контексте архитектур Faster rcnn и Mask rcnn?

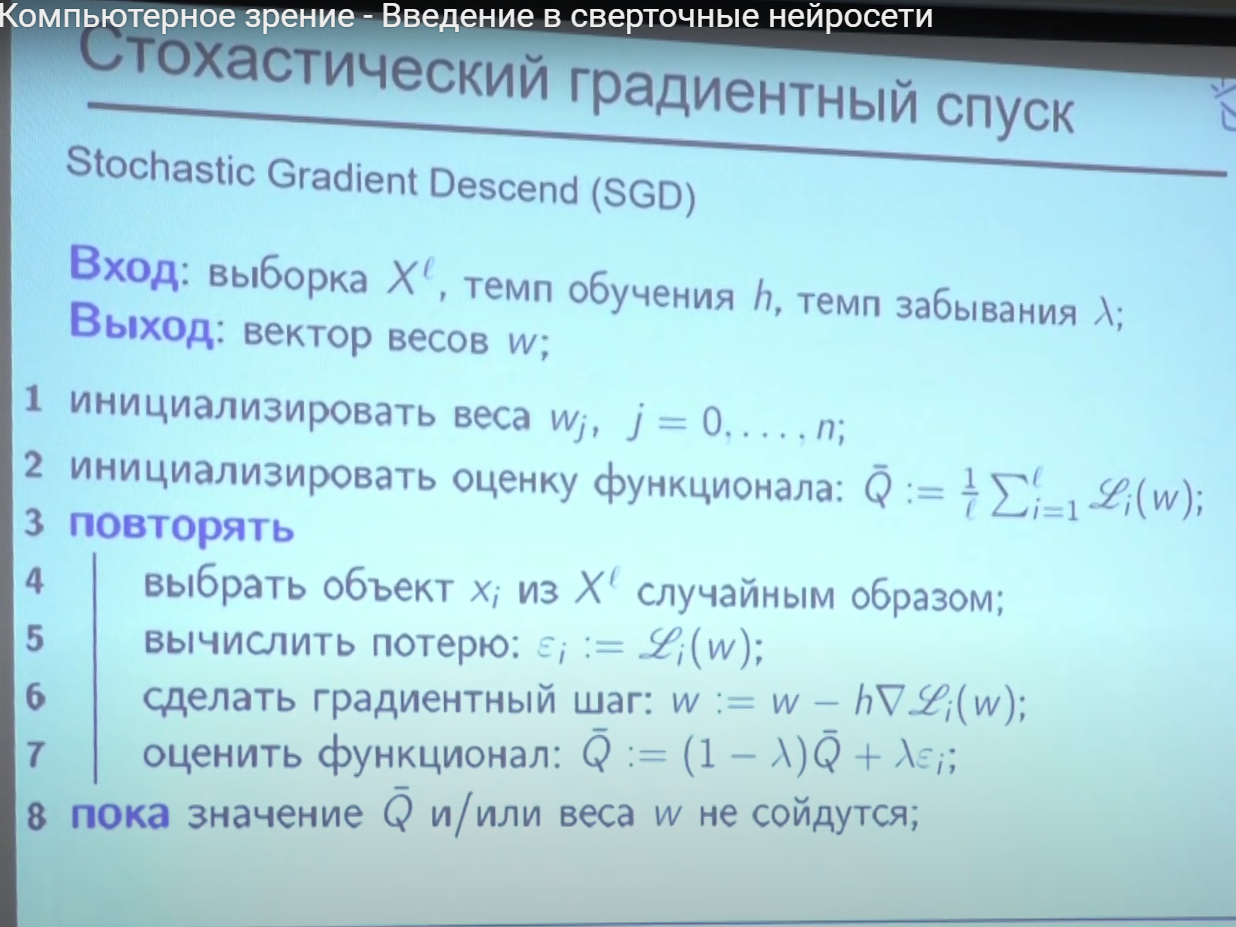

Алгоритм стохастического градиентного спуска для обучения нейронных сетей

Стохастический градиентный спуск – итерационный метод для оптимизации целевой функции с подходящими свойствами гладкости (например, дифференцируемость или субдифференцируемость).

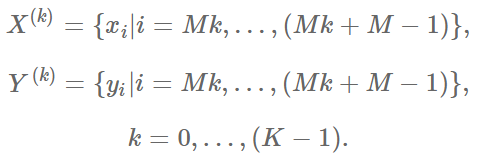

При наличии достаточно большого тренировочного набора, вычислять функцию ошибки по всем элементам этого набора, задача весьма затратная по ресурсам. Поэтому разобьём набор на K частей (minibatch) размера M:

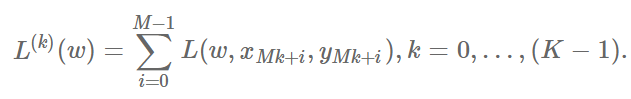

определим функции:

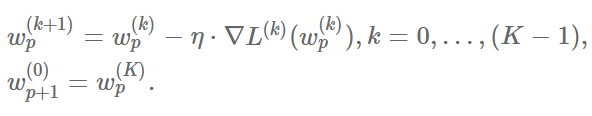

И вместо одной итерации градиентного спуска у нас появляется набор из K мини-итераций вида:

Каждую “большую” итерацию (p=0,1,2,…), когда мы проходим весь набор, будем называть эпохой (epoch). Между эпохами тренировочный набор перемешивается, чтобы элементы попадали в разные минибатчи в разных эпохах. Таким образом, L^(k)(w) вообще говоря суммируются по разным поднаборам X,Y для разных эпох (при фиксированном k).

Метод стохастического градиентного спуска, позволяет решить проблему требовательности к ресурсам обычного градиентного спуска, однако, ставит много новых вопросов, например, какого размера выбирать минибатчи.

Как инициализируют веса в нейронных сетях? Что такое проблема затухающих и взрывающихся градиентов? Что такое инициализация Хе (Кайминга) и Ксавье?

Принцип выбора начальных значений весов для слоев, составляющих модель очень важен: установка всех весов в 0 будет серьезным препятствием для обучения, так как ни один из весов изначально не будет активен. Присваивать весам значения из интервала [−1,1] — тоже обычно не лучший вариант — на самом деле, иногда (в зависимости от задачи и сложности модели) от правильной инициализации модели может зависеть, достигнет она высочайшей производительности или вообще не будет сходиться. Даже если задача не предполагает такой крайности, удачно выбранный способ инициализации весов может значительно влиять на способность модели к обучению, так как он предустанавливает параметры модели с учетом функции потерь.

Всегда можно выбрать случайно начальное приближение, но лучше выбирать определённым образом, ниже приведены самые распространённые из них:

Метод инициализации Завьера (Xavier) (иногда — метод Glorot’а). Основная идея этого метода — упростить прохождение сигнала через слой во время как прямого, так и обратного распространения ошибки для линейной функции активации (этот метод также хорошо работает для сигмоидной функции, так как участок, где она ненасыщена, также имеет линейный характер). При вычислении весов этот метод опирается на вероятностное распределение (равномерное или нормальное) с дисперсией, равной Var(W) = 2 / (n_in + n_out), где n_in и n_out – количества нейронов в предыдущем и последующем слоях соответственно;

Метод инициализации Ге (He) — вариация метода Завьера, больше подходящая функции активации ReLU, компенсирующая тот факт, что эта функция возвращает нуль для половины области определения. А именно, в этом случае Var(W) = 2 / n_in.

>проблема затухающих и взрывающихся градиентов

Напомним, что градиентом в нейронных сетях называется вектор частных производных функции потерь по весам нейронной сети. Таким образом, он указывает на направление наибольшего роста этой функции для всех весов по совокупности. Градиент считается в процессе тренировки нейронной сети и используется в оптимизаторе весов для улучшения качества модели.

В процессе обратного распространения ошибки при прохождении через слои нейронной сети в элементах градиента могут накапливаться большие значения, что будет приводить к сильным изменениям весов. Это в свою очередь может сделать нестабильным алгоритм обучения нейронной сети. В таком случае элементы градиента могут переполнить тип данных, в котором они хранятся. Такое явление называется взрывающимся градиентом.

Существует аналогичная обратная проблема, когда в процессе обучения при обратном распространении ошибки через слои нейронной сети градиент становится все меньше. Это приводит к тому, что веса при обновлении изменяются на слишком малые значения, и обучение проходит неэффективно или останавливается, то есть алгоритм обучения не сходится. Это явление называется затухающим градиентом.

Таким образом, увеличение числа слоев нейронной сети с одной стороны увеличивает ее способности к обучению и расширяет ее возможности, но с другой стороны может порождать данную проблему.