- •Источники информации

- •Структурные меры информации

- •Статистические меры информации

- •Количество информации и избыточность

- •Лекция №2 Квантование информации

- •Равномерная дискретизация

- •Выбор частоты отсчетов

- •Квантование по уровню

- •Лекция №3 Кодирование информации

- •Цифровое кодирование

- •Эффективное кодирование

- •Помехоустойчивое кодирование

- •Коды компьютерных интерфейсов

- •Лекция №4 Модуляция носителей информации

- •Модуляция и кодирование

- •Спектры сигналов Амплитудная модуляция

- •Частотная и фазовая модуляция

- •Спектры одиночных импульсов

- •Спектры сигналов с импульсной модуляцией

- •Лекция №5 Передача информации

- •Виды каналов передачи Механические каналы

- •Акустические каналы

- •Оптические каналы

- •Электрические каналы

- •Временное разделение

- •Фазовое разделение

- •Корреляционное разделение

- •Дискретный канал без помех

- •Дискретный канал с помехами

- •Скорость передачи информации

- •Повышение помехоустойчивости передачи и приема

- •Лекция №7 Восприятие и обработка информации Задачи распознавания, обнаружения и измерения

- •Обнаружение и распознавание

- •Характеристики качества распознавания

- •Статистические критерии обнаружения

- •Критерий минимального риска Байеса

- •Лекция №8 Общие подходы к организации локальных вычислительных систем (лвс)

- •Эталонный модуль (эм) архитектуры лвс

- •Технические средства лвс Каналы связи лвс

- •Системы передачи данных (спд) на базе электрических кабелей

- •Электромеханические ответвители

- •Системы передачи данных оптического типа Волоконно-оптические кабели

- •Оптоэлектронные преобразователи

- •Вопросы и задания для самостоятельной работы и практических занятий

- •Вариант 1

- •Вариант 2

- •Заключение

- •Библиографический список

- •Оглавление

- •3 94006 Воронеж, ул. 20-летия Октября, 84

Министерство образования и науки РФ

Федеральное государственное бюджетное образовательное учреждение

высшего профессионального образования

«Воронежский государственный архитектурно-строительный университет»

Ю.В. Авдеев, А.В. Полуказаков

Системы передачи информации

Конспект лекций

Рекомендовано в качестве учебного пособия

редакционно-издательским советом

Воронежского государственного архитектурно-строительного университета для студентов, обучающихся по специальности

«Автоматизация технологических процессов

и производств (в строительстве)»

Воронеж 2012

УДК 004.451.622(07)

ББК 32.973.202я7

А187

Рецензенты:

кафедра электромеханических систем и электроснабжения Воронежского государственного технического университета;

С. А. Чепелев, д. т. н., проф. Воронежской государственной лесотехнической академии

-

А187

Авдеев Ю. В.

Системы передачи информации: конспект лекций / Ю. В. Авдеев,

А. В. Полуказаков; Воронежский ГАСУ. – Воронеж, 2012. ‑ 57 с.

Рассматриваются вопросы, связанные с системами передачи информации. Содержит тексты лекций, а также задания для практических занятий и самостоятельной работы, кроме того позволит более глубоко изучить и усвоить теоретические знания, приобрести практические навыки, необходимые инженеру по автоматизации в практической деятельности.

Предназначен для студентов специальности 220301 «Автоматизация технологических процессов и производств (в строительстве)».

Ил. 34. Табл. 7. Библиогр.: 5 назв.

|

УДК 004.451.622(07) ББК 32.973.202я7 |

ISBN 978-5-89040-382-7

|

© Ю.В. Авдеев, А.В. Полуказаков, 2012 © Воронежский ГАСУ, 2012 |

Введение

Повышение эффективности управления производством невозможно без использования систем автоматизации технологических процессов и производств (АТПП).

Системы передачи информации (СПИ) являются составной частью комплекса технических средств систем АТПП. Теория информации занимает базовое положение и устанавливает количественные характеристики информации, определяет физические и статистические параметры каналов связи, в теории формулируются условия согласования источников информации с каналами связи и предлагается использование кодирования для повышения помехоустойчивости передачи информации по каналам связи с шумом.

Существенное внимание уделяется вопросам преобразования аналоговых сигналов, снимаемых с датчиков, в дискретные.

Теоретическая часть учебного пособия представлена восемью лекциями (темами). К каждой из тем прилагаются задания для практического усвоения лекционного материала. Изучение дисциплины потребует от студента определенных знаний из курса «Математика»: теории вероятностей, ортогональных функций, преобразования Фурье.

Оценка качества функционирования систем АТПП требует комплексного учета качества функционирования как технических средств систем АТПП, где возмущающими воздействиями выступают неисправности аппаратуры (постепенные или мгновенные отказы (сбой)), так и систем передачи информации при действии помех в каналах связи.

Проблемы оптимизации систем передачи информации были поставлены и частично решены одним из основоположников теории информации американским ученым К. Шенноном в работе «Математическая теория связи», вышедшей в 1948 году. Работа «Теория потенциальной помехоустойчивости» была опубликована советским ученым В.А. Котельниковым в 1946 году. Эти работы создали теоретическую базу для бурного развития современных систем передачи информации.

Так как конспект лекций ориентирован на студентов с различной подготовкой, то математический уровень постараемся свести к минимально необходимому для объяснения основных обсуждаемых вопросов. С другой стороны, на практических занятиях обсуждаются вопросы, которые кажутся наиболее интересными и увлекательными с точки зрения математического или прикладного характера.

Хорошие результаты в части освоения материала курса были получены при использовании перекрестного самотестирования по предварительно составленным дома вопросам по материалам предыдущей лекции на основе электронного конспекта (обычно 10 вопросов). Это в какой-то степени подготавливает студентов к освоению нового материала и вызывает у них большее понимание.

Лекция №1

Понятие информации и меры информации

Философское определение информации: информация есть отражение реального мира.

Практическое: информация есть все сведения, являющиеся объектом хранения, передачи и преобразования.

Понятие информации связано с некоторыми моделями реальных вещей, отражающими их сущность в той степени, в какой это необходимо для практических целей.

Под информацией надо понимать не сами объекты и процессы, а их характеристики, отражения или отображения в виде чисел, формул, описаний, чертежей, символов, образов и других абстрактных характеристик.

С передачей и обработкой информации связаны действия любого автоматического устройства, поведения живого существа, творческая деятельность человека, развитие науки и техники, экономические и социальные преобразования в обществе и сама жизнь.

Фазы обращения информации

Фазы обращения информации представлены на рис. 1.1.

Рис. 1.1

Восприятие формирует образ объекта. В эту фазу входят операции:

нормализации информации,

квантования,

кодирования,

модуляции сигналов.

Передача информации заключается в переносе ее на расстояние посредством сигналов различной физической природы по механическим, гидравлическим, пневматическим, акустическим, оптическим, электрическим или электромагнитным каналам. Прием информации на другой стороне канала носит характер вторичного восприятия с процедурами борьбы с шумами.

Обработка информации решает задачи преобразования информации. Промежуточным этапом обработки может быть хранение информации в запоминающих устройствах.

Представление информации необходимо, когда в цикле обращения информации участвует человек.

Воздействие информации включает выработку управляющих воздействий для изменения состояния объекта.

Измерение информации

Важнейшим вопросом теории информации является установление меры количества и качества информации.

Информационные меры отвечают трем основным направлениям теории информации:

структурному,

статистическому,

семантическому.

Структурная теория рассматривает дискретное строение массивов информации и их измерение простым подсчетом информационных элементов (квантов).

Статистическая теория оперирует понятием энтропии как меры неопределенности, учитывающей вероятность появления, а следовательно, и информативность тех или иных сообщений.

Семантическая теория учитывает целесообразность, ценность, полезность или существенность информации.

Структурная теория применяется для оценки возможностей аппаратуры информационных систем (каналов связи, запоминающих и регистрирующих устройств) независимо от условий применения.

Статистическая теория дает оценки информационных систем в конкретных условиях (канал с определенными статистическими характеристиками).

Семантическая теория прилагается к оценке эффективности логического опыта.

Источники информации

Источники информации и создаваемые ими сообщения разделяются на следующие:

дискретные,

непрерывные.

Дискретные сообщения слагаются из счетного множества элементов, создаваемых источником последовательно во времени.

Дискретный источник в конечное время создает конечное множество сообщений.

Непрерывные сообщения отражаются какой-либо физической величиной, изменяющейся в заданном интервале времени. В этом случае получение конечного множества сообщений за конечный промежуток времени предполагает дискретизацию (во времени) и квантование (по уровню).

Структурные меры информации

Информационный элемент – квант (неделимая часть информации).

Различают:

геометрическую,

комбинаторную,

аддитивную меры информации.

Наибольшее распространение получила двоичная аддитивная логарифмическая мера (мера Хартли), измеряющая количество информации в двоичных единицах (битах). Для сообщения (числа) (рис. 1.2) Q= hN ,

где N- количество элементов (разрядов, длина) числа,

h – количество фиксированных состояний (основание системы числа).

Рис. 1.2

Количество информации по Хартли:

I = log2 Q = Nlog2 h (бит).

Если N=1, h=2 (двоичная система), то I=1*log2 2= 1 бит.

При наличии нескольких источников общее количество информации от всех источников:

I (Q1 ……..QS) = I(Q1) + ……+I(QS).

Удельной информативностью называют количество информации на один элемент:

I1= =log2h.

=log2h.

Статистические меры информации

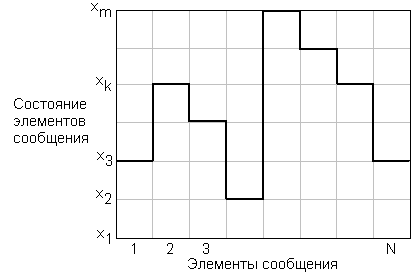

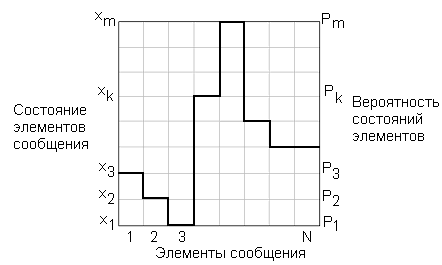

Рис. 1.3

Рассмотрим сообщение (рис. 1.3) из N элементов, каждый из которых может принимать любое из m состояний х1, . . .хк, . . .хm с вероятностью р1,. . рк,. .рm.

Средняя информация в битах

.

.

Шеннон назвал эту величину энтропией, т.е.

H= Icр.

Энтропия характеризуется следующими свойствами:

1. Энтропия всегда неотрицательна.

2. Энтропия равна 0, когда одно событие имеет вероятность 1, остальные – 0, т.е. этот опыт не несет новой информации.

3. Энтропия имеет наибольшее значение при р1= р2 =. . рm= 1/m, при этом Нmax= - log21/m = log 2m.

Очевидно, если m=h, то удельная информативность по Хартли и энтропия Шеннона совпадают. Это совпадение будет означать полное использование информационной емкости системы. В случае неравных вероятностей количество информации по Шеннону меньше информационной емкости системы.

Количество информации и избыточность

Наибольшее количество информации получается тогда, когда полностью снимается неопределенность, причем эта неопределенность была наибольшей, т.е. вероятности всех событий одинаковы. Это соответствует значению, оцениваемому мерой Хартли:

Нmax= log2m = log2(1/р) = - log2p.

Абсолютная избыточность информации:

Dабс=

Нmax-H,

т.е. разность между максимально возможным

количеством информации Нmax

и энтропией:

.

.

В ряде случаев используется понятие относительной избыточности

=

=

.

.

Лекция №2 Квантование информации

Основные понятия и определения

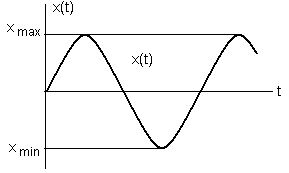

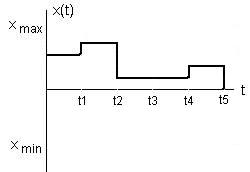

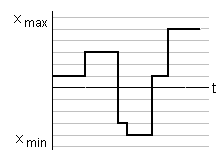

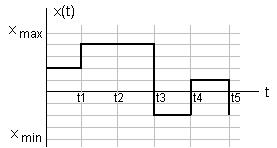

Непрерывные сигналы описываются непрерывными функциями х(t).

Переход от аналогового представления к цифровому дает значительные преимущества при передаче, хранении и обработке информации и связан с квантованием (дискретизацией) сигнала х(t) по времени и уровню.

Функция х(t) (рис. 2.1) описывает следующие разновидности сигналов:

|

|

а) непрерывная функция непрерывного аргумента |

б) непрерывная функция дискретного аргумента |

|

|

в) дискретная функция непрерывного аргумента |

г) дискретная функция дискретного аргумента |

Рис. 2.1

Все сигналы (процессы) можно разделить на детерминированные и случайные. Детерминированные сигналы описываются точными математическими соотношениями и могут быть периодическими и непериодическими. Многие физические процессы невозможно описать точными математическими соотношениями. Предсказать точные значения для этих процессов невозможно. Такие процессы являются случайными.

В результате эксперимента получаем реализацию из множества возможных реализаций случайного процесса.

Дискретизация сигнала х (t) означает замену х (t) совокупностью отдельных значений х (ti).

По значениям х (ti) можно восстановить исходную функцию х (t) с некоторой погрешностью.

При дискретизации

решается проблема: каков должен быть

шаг дискретизации

?

?

Оптимальным является шаг, который обеспечивает представление исходного сигнала с заданной точностью при минимальном количестве выборок.

Избыточные отсчеты не увеличивают точность восстановления, загружают тракт передачи информации, уменьшают производительность обработки данных в ЭВМ и т.д.

Сокращение избыточных данных – актуальная задача и может решаться в процессе дискретизации.